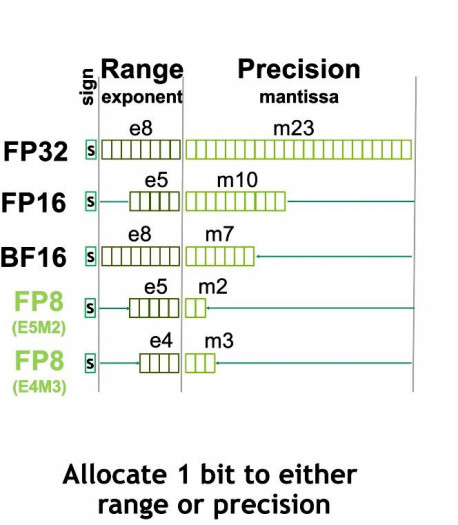

Erfolge mit Bfloat16 - Flexpoint, Bfloat16, TensorFloat32, FP8: Dank KI zu neuen Gleitkommazahlen - Golem.de

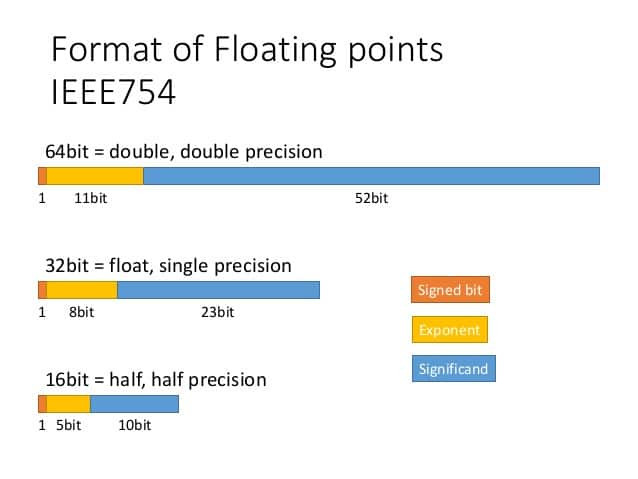

Bfloat16 has worse performance than float16 for conv2d in Pytorch - CUDA Programming and Performance - NVIDIA Developer Forums

Erfolge mit Bfloat16 - Flexpoint, Bfloat16, TensorFloat32, FP8: Dank KI zu neuen Gleitkommazahlen - Golem.de

Bfloat16 has worse performance than float16 for conv2d in Pytorch - CUDA Programming and Performance - NVIDIA Developer Forums